Cerebras предлагает «мгновенный» ИИ

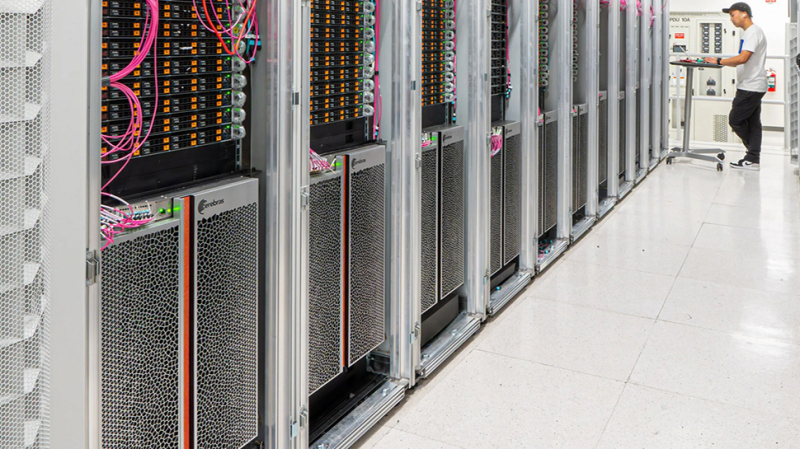

Компания Cerebras представила свой новейший чип для обработки искусственного интеллекта, который позиционируется как грозный конкурент DGX100 от Nvidia.

Чип оснащен 44 ГБ высокоскоростной памяти, что позволяет ему обрабатывать модели ИИ с миллиардами и триллионами параметров.

Для моделей, которые превосходят емкость памяти одной пластины, Cerebras может разделить их на границах слоев, распределив их по нескольким системам CS-3. Одна система CS-3 может вместить 20 миллиардов моделей параметров, в то время как 70 миллиардов моделей параметров могут управляться всего четырьмя системами.

Скоро появится дополнительная поддержка моделей

Cerebras подчеркивает использование 16-битных весов модели для поддержания точности, в отличие от некоторых конкурентов, которые снижают точность веса до 8 бит, что может ухудшить производительность. По словам Cerebras, его 16-битные модели работают на 5% лучше в многооборотных разговорах, математике и задачах рассуждения по сравнению с 8-битными моделями, обеспечивая более точные и надежные выходные данные.

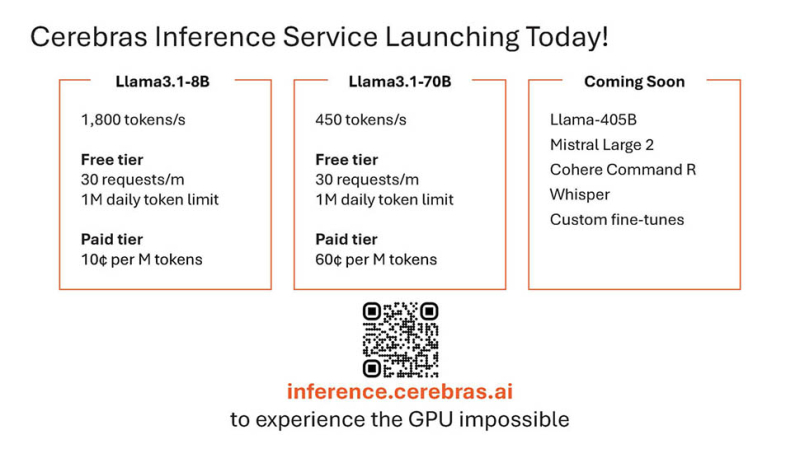

Платформа вывода Cerebras доступна через чат и API-доступ и разработана для легкой интеграции разработчиками, знакомыми с форматом OpenAI Chat Completions. Платформа может похвастаться возможностью запуска моделей Llama3.1 70B со скоростью 450 токенов в секунду, что делает ее единственным решением для достижения мгновенной скорости для таких больших моделей. Для разработчиков Cerebras предлагает 1 миллион бесплатных токенов ежедневно при запуске, при этом цены на крупномасштабные развертывания, как говорят, значительно ниже, чем в популярных облаках GPU.

Cerebras изначально запускается с моделями Llama3.1 8B и 70B, с планами добавить поддержку более крупных моделей, таких как Llama3 405B и Mistral Large 2, в ближайшем будущем. Компания подчеркивает, что возможности быстрого вывода имеют решающее значение для обеспечения более сложных рабочих процессов ИИ и улучшения интеллекта LLM в реальном времени, особенно в таких методах, как скаффолдинг, который требует значительного использования токенов.

Патрик Кеннеди из ServeTheHome На недавнем симпозиуме Hot Chips 2024 я увидел продукт в действии, отметив: «У меня была возможность посидеть с Эндрю Фельдманом (генеральным директором Cerebras) перед выступлением, и он показал мне демонстрации вживую. Это неприлично быстро. Причина, по которой это важно, заключается не только в том, чтобы человек мог подсказать взаимодействие. Вместо этого в мире агентов, где компьютерные агенты ИИ разговаривают с несколькими другими компьютерными агентами ИИ. Представьте себе, что каждому агенту требуются секунды, чтобы выдать результат, и в этом конвейере есть несколько шагов. Если вы думаете об автоматизированных конвейерах агентов ИИ, то вам нужен быстрый вывод, чтобы сократить время для всей цепочки».

Cerebras позиционирует свою платформу как установку нового стандарта в разработке и развертывании открытых LLM, предлагая рекордную производительность, конкурентоспособные цены и широкий доступ к API. Вы можете попробовать ее, перейдя на inference.cerebras.ai или отсканировав QR-код на слайде ниже.

REFLECTION Llama3.1 70b Tested on Ollama Home Ai Server - Best Ai LLM?

The buzz about the new Reflection Llama 3.1 Fine Tune being the worlds best LLM is all over the place, and today I am testing it ...

Больше на 每天都有技术

Subscribe to get the latest posts sent to your email.